Ferret-UI是由苹果开发的一个专门理解和与移动用户界面(UI)互动的多模态大语言模型(MLLM)。

它把移动UI的视觉元素和语言元素结合起来,不仅能“看懂”屏幕上的内容,还能理解用户的指令和问题,进而执行任务或提供信息。

Ferret-UI结合了最新的进展在自然语言处理(NLP)和计算机视觉(CV)领域,提供了一个强大的工具,旨在改善机器对移动应用界面的理解能力。通过具体地分析和处理移动设备上的UI元素,Ferret-UI能够识别和推理这些界面的内容和功能,为开发者和研究人员提供了一种新的方式来探索和利用UI数据。

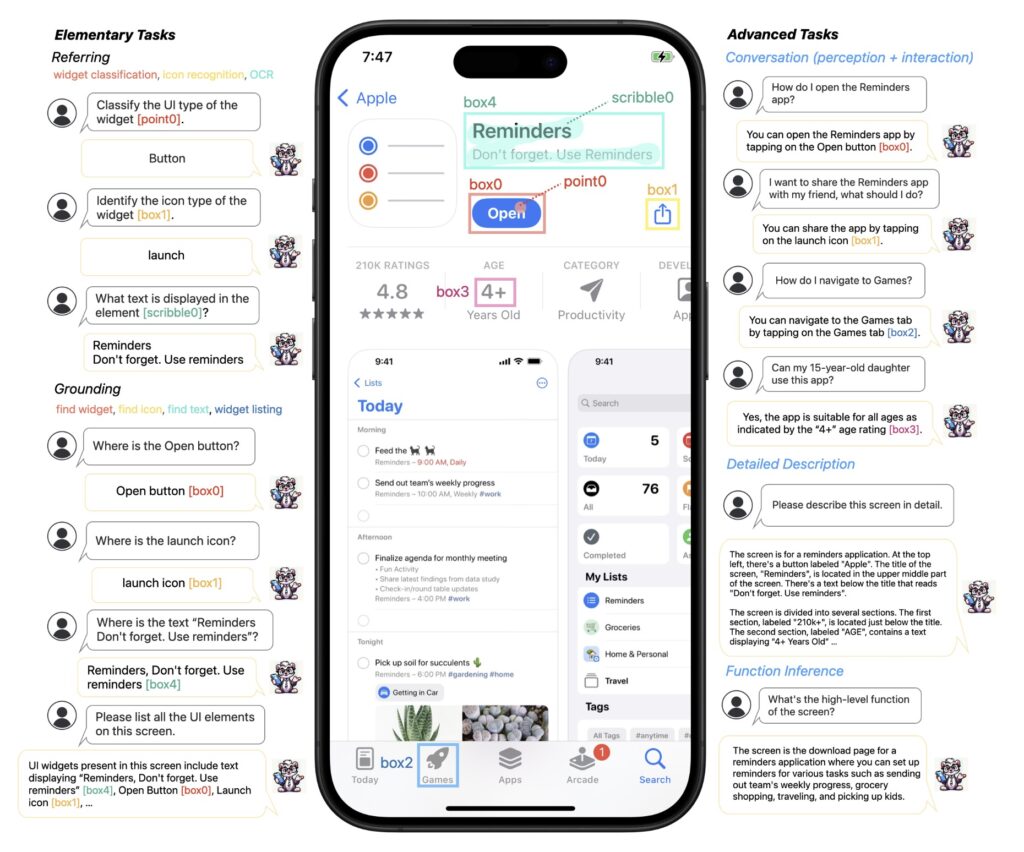

Ferret-UI展示了其在移动UI屏幕上执行指代任务(如小部件分类、图标识别、OCR)和定位任务(如查找小部件、查找图标、查找文本、小部件列表)的能力,支持灵活的输入格式(如点、框、涂鸦)。

这些基础任务为模型提供了丰富的视觉和空间知识,使其能够在粗略和细致的层面上区分不同的UI类型,例如不同的图标或文本元素。这种基础知识对于执行更高级的任务至关重要。具体来说,Ferret-UI不仅能够详细描述和讨论视觉元素、进行感知对话,还能在互动对话中提出目标导向的行动,并通过功能推断来推测屏幕的总体功能。

这说明了Ferret-UI在理解和交互移动用户界面方面的高级能力,不仅仅是在识别和分类层面,还包括能够进行复杂的推理和交互,从而为开发自动化测试、无障碍应用以及提升用户体验的应用提供了强大的技术支持。

主要功能:

-

指代和定位:Ferret-UI具备指代(referring)和定位(grounding)能力,能够识别和处理屏幕上特定的UI元素,如图标、文本和小部件。这意味着模型能够根据自然语言指令识别和定位屏幕上的具体对象。

比如,当你看到一个移动应用里的按钮或者图标时,你能识别它并知道它的功能。Ferret-UI也能做到这一点,它能识别屏幕上的各种元素,比如图标、文本和按钮。

Support authors and subscribe to content

This is premium stuff. Subscribe to read the entire article.

字幕酱是一个在线字幕生成工具,利用 AI 深度学习技术,提供自动字幕生成、字幕翻译、字幕格式转换等功能。