DeepSeek宣布发布开源模型DeepSeek-Coder-V2,该模型在代码和数学能力上超越了GPT-4-Turbo,成为全球首个在这些领域竞争的开源模型。DeepSeek-Coder-V2基于DeepSeek-V2的模型结构,总参数236B,激活参数21B,具有全球顶尖的代码和数学能力,并在多个排行榜上位居全球第二,次于GPT-4o和GPT-4-Turbo之间。同时,它在中英通用能力上也表现出色,位列国内第一梯队。

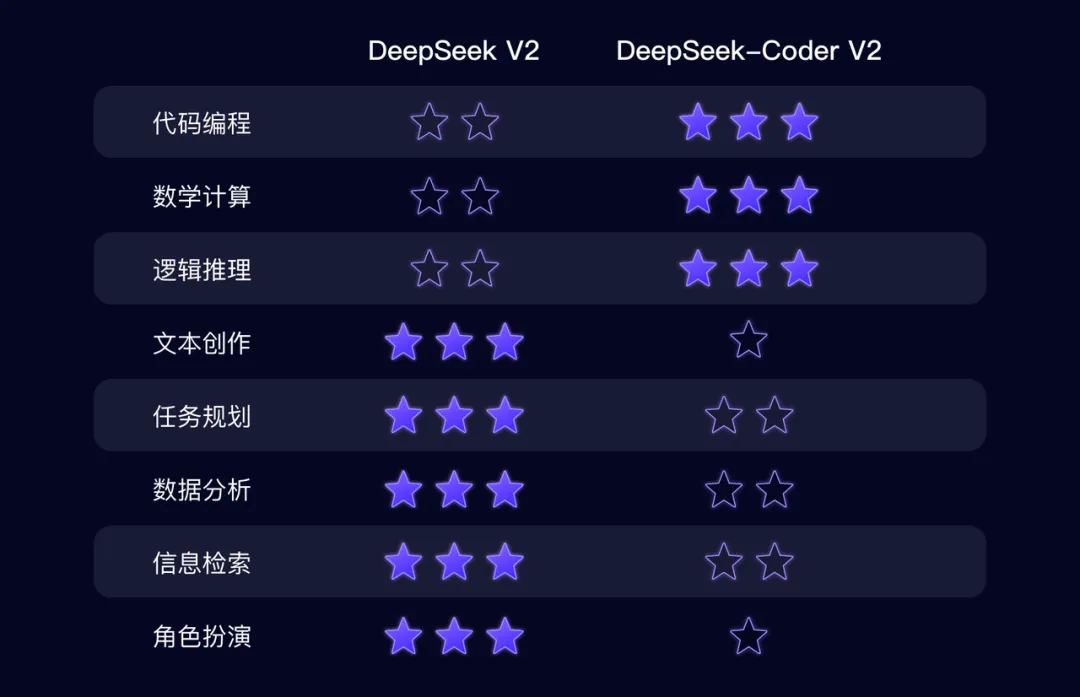

DeepSeek-Coder-V2与DeepSeek-V2相比,各有所长,前者更擅长理科,后者更擅长文科。该模型和相关代码、论文全部开源,免费商用,无需申请,提供两种规模:236B和16B,并支持API服务和本地私有化部署。

全球顶尖的代码、数学能力

模型架构

DeepSeek-Coder-V2采用专家混合(Mixture-of-Experts, MoE)架构,专门设计用于增强代码和数学推理能力。以下是该模型的一些关键架构特点:

- 专家混合(MoE)架构:通过多个专家模型的协同工作来处理复杂任务,显著提高了模型的推理能力和效率。

- 进一步预训练:基于DeepSeek-Coder-V2-Base,从高质量和多源语料库中提取6万亿个token进行预训练,增强了编码和数学推理能力。

- 多语言支持:支持的编程语言从86种扩展到338种,适应更多样化的开发需求。

- 扩展上下文长度:支持的上下文长度从16K扩展到128K,能够处理更长的输入内容。

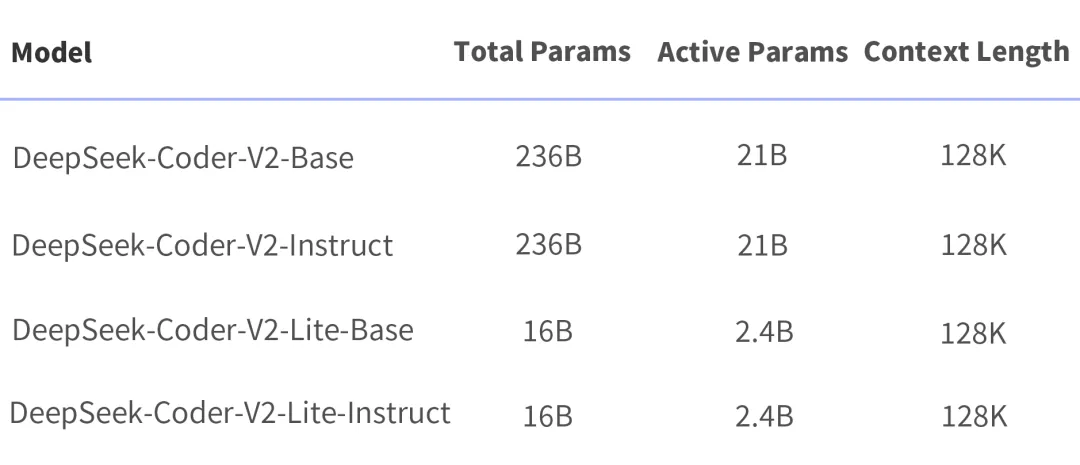

模型规模

DeepSeek-Coder-V2提供了两种规模的模型,分别为236B参数和16B参数,满足不同的应用需求:

-

DeepSeek-Coder-V2:总参 236B(即官网和 API 版模型),单机 8*80G 可部署,单机 8*80G 可微调(需要技巧) -

DeepSeek-Coder-V2-Lite:总参 16B,激活 2.4B,支持 FIM,代码能力接近 DeepSeek-Coder-33B(V1),单卡 40G 可部署,单机 8*80G 可训练。

DeepSeek-Coder-V2 和 DeepSeek-V2 的差异

DeepSeek-Coder-V2 和 DeepSeek-V2 的差异

API服务

API服务

DeepSeek-Coder-V2 API 支持 32K 上下文,价格和 DeepSeek-V2 一致,还是大家熟悉的低价:

评估结果

评估结果

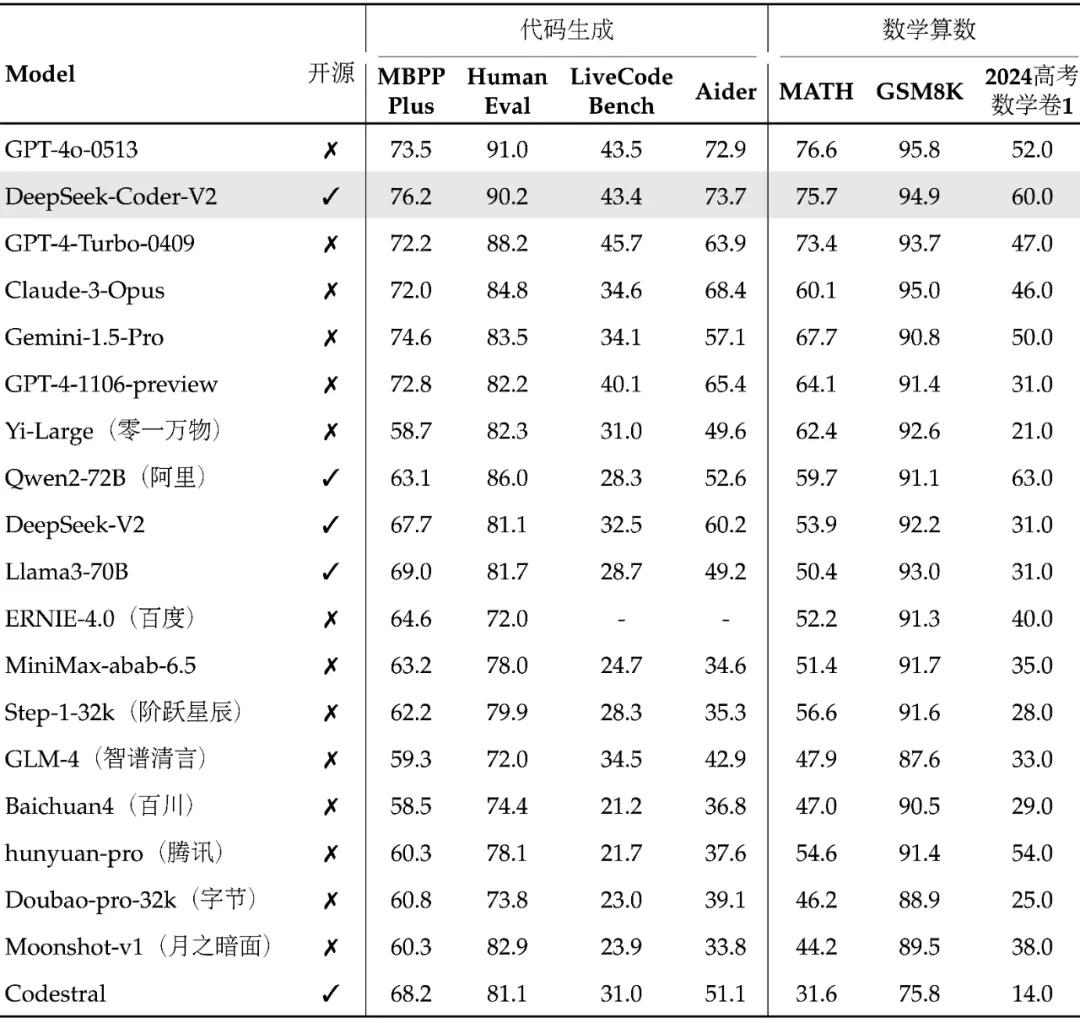

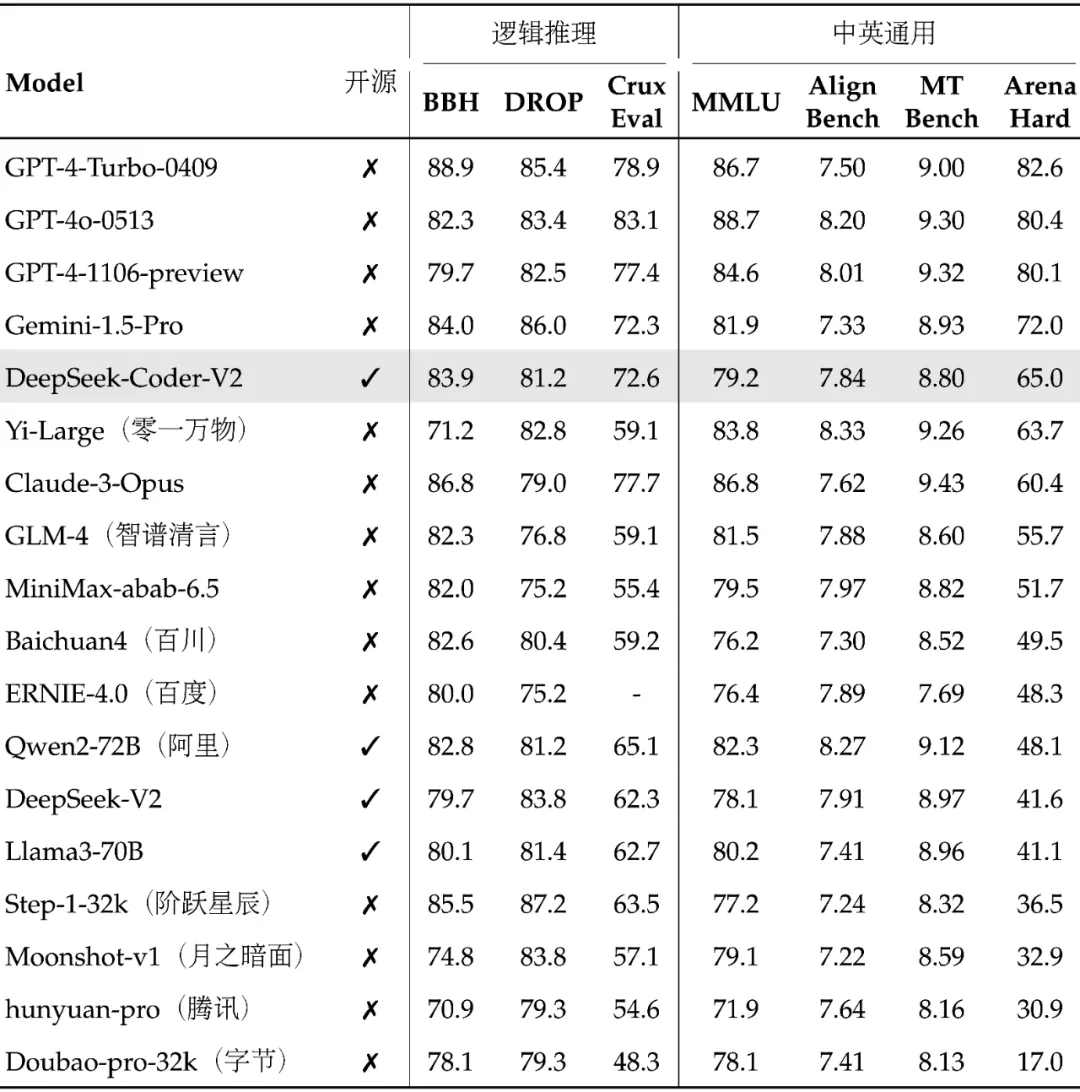

在标准的基准测试中,DeepSeek-Coder-V2的性能优于一些闭源模型,例如GPT4-Turbo、Claude 3 Opus和Gemini 1.5 Pro,特别是在代码生成和数学推理的测试中。

1. 代码生成

在多个代码生成基准测试中,DeepSeek-Coder-V2表现优异,特别是在HumanEval、MBPP+、LiveCodeBench和USACO等测试中,显著超越了许多闭源和开源模型。

| 模型 | 参数量 | HumanEval | MBPP+ | LiveCodeBench | USACO |

|---|---|---|---|---|---|

| GPT-4o-0513 | 闭源 | 91.0 | 73.5 | 43.4 | 18.8 |

| GPT-4-Turbo-0409 | 闭源 | 88.2 | 72.2 | 45.7 | 12.3 |

| GPT-4-Turbo-1106 | 闭源 | 87.8 | 69.3 | 37.1 | 11.1 |

| DeepSeek-Coder-V2-Instruct | 236B | 90.2 | 76.2 | 43.4 | 12.1 |

| DeepSeek-Coder-V2-Lite-Instruct | 16B | 81.1 | 68.8 | 24.3 | 6.5 |

2. 代码补全

在RepoBench和HumanEval FIM测试中,DeepSeek-Coder-V2也显示出强大的代码补全能力。

| 模型 | 参数量 | RepoBench (Python) | RepoBench (Java) | HumanEval FIM |

|---|---|---|---|---|

| GPT-4o-0513 | 闭源 | 46.1 | 45.7 | 86.4 |

| DeepSeek-Coder-V2-Instruct | 236B | 43.1 | 44.8 | 86.4 |

| DeepSeek-Coder-V2-Lite-Base | 16B | 38.9 | 43.3 | 86.4 |

3. 代码修复

在Defects4J和SWE-Bench测试中,DeepSeek-Coder-V2的表现也十分突出。

| 模型 | 参数量 | Defects4J | SWE-Bench | Aider |

|---|---|---|---|---|

| GPT-4o-0513 | 闭源 | 26.1 | 26.7 | 72.9 |

| GPT-4-Turbo-0409 | 闭源 | 24.3 | 18.3 | 63.9 |

| DeepSeek-Coder-V2-Instruct | 236B | 21.0 | 12.7 | 73.7 |

| DeepSeek-Coder-V2-Lite-Instruct | 16B | 9.2 | 0.0 | 44.4 |

4. 数学推理

在GSM8K、MATH、AIME 2024和Math Odyssey等数学推理基准测试中,DeepSeek-Coder-V2表现卓越。

| 模型 | 参数量 | GSM8K | MATH | AIME 2024 | Math Odyssey |

|---|---|---|---|---|---|

| GPT-4o-0513 | 闭源 | 95.8 | 76.6 | 2/30 | 53.2 |

| GPT-4-Turbo-0409 | 闭源 | 93.7 | 73.4 | 3/30 | 46.8 |

| DeepSeek-Coder-V2-Instruct | 236B | 94.9 | 75.7 | 4/30 | 53.7 |

| DeepSeek-Coder-V2-Lite-Instruct | 16B | 86.4 | 61.8 | 0/30 | 44.4 |

5. 自然语言处理

在BBH、MMLU、ARC等自然语言处理基准测试中,DeepSeek-Coder-V2也取得了令人瞩目的成绩。

| 测试 | 领域 | DeepSeek-V2-Lite Chat | DeepSeek-Coder-V2-Lite Instruct | DeepSeek-V2 Chat | DeepSeek-Coder-V2 Instruct |

|---|---|---|---|---|---|

| BBH | 英文 | 48.1 | 61.2 | 79.7 | 83.9 |

| MMLU | 英文 | 55.7 | 60.1 | 78.1 | 79.2 |

| ARC-Easy | 英文 | 86.1 | 88.9 | 98.1 | 97.4 |

| ARC-Challenge | 英文 | 73.4 | 77.4 | 92.3 | 92.8 |

| TriviaQA | 英文 | 65.2 | 59.5 | 86.7 | 82.3 |

| NaturalQuestions | 英文 | 35.5 | 30.8 | 53.4 | 47.5 |

| CLUEWSC | 中文 | 80.0 | 76.5 | 89.9 | 85.9 |

| C-Eval | 中文 | 60.1 | 61.6 | 78.0 | 79.4 |

| CMMLU | 中文 | 62.5 | 62.7 | 81.6 | 80.9 |

6. 上下文窗口

在Needle In A Haystack (NIAH)测试中,DeepSeek-Coder-V2在所有上下文窗口长度(最长达128K)上表现出色。

模型下载:

- DeepSeek-Coder-V2-Lite-Base

- DeepSeek-Coder-V2-Lite-Instruct

- DeepSeek-Coder-V2-Base

- DeepSeek-Coder-V2-Instruct

在线体验: coder.deepseek.com

GitHub:https://github.com/deepseek-ai/DeepSeek-Coder-V2

斑头雁BattleYeah AI,AI机器人构建平台,简单、易用、全新交互形式,API无缝集成至企业系统,帮助企业实现AI生产力革命。