手语是聋哑人之间以及他们与外界沟通的重要工具,然而,许多不会手语的人无法与他们有效交流。这个项目的目标是通过自动检测手语手势,构建一个可以帮助聋哑人和普通人之间沟通的桥梁,提升手语翻译的自动化和效率。

YOLO是一种实时物体检测算法,它能够在视频或图像中快速准确地识别和定位目标。

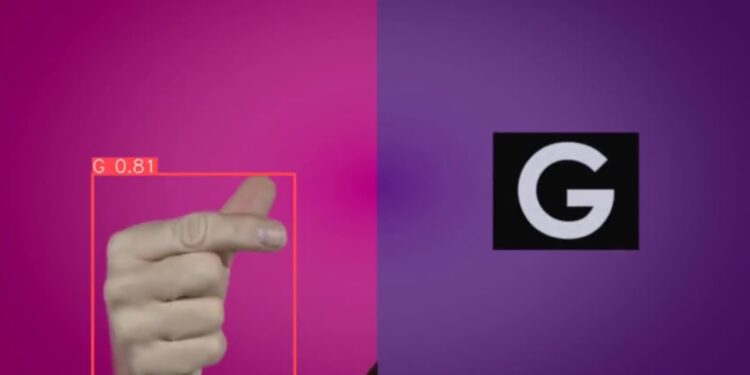

该项目通过使用YOLOv11 模型来检测和分类手语手势,从而构建一个能够自动识别手语的系统。

视频播放器

00:00

00:00

- YOLOv11 物体检测模型:

- YOLO 是一种一次性预测物体框架的技术,与传统的区域推荐网络相比,它在实时处理能力上更为出色,特别适合用于视频流和实时检测。

- YOLOv11 是 YOLO 系列中的最新版本,优化了检测速度和准确度,能够在较低的计算资源下提供高效的检测性能。

- 在这个项目中,YOLOv11 被用于识别视频中的手语手势,模型能够识别多个手势类别,并在图像或视频中精确定位手语的区域。

- 通过高效的 GPU 加速,模型能够以较低的延迟提供高精度的检测结果,适合用于实时手语翻译系统。

- 手语数据集(Asl_Videos):

- 项目使用的训练数据来自 Asl_Videos 数据集,这是一个用于手语识别的大型视频数据集,包含了大量不同手语手势的视频样本。

- 数据集中的视频样本经过处理并标注,确保 YOLO 模型能够从中学习到有效的手语手势特征。通过这些视频数据,YOLO 模型能够准确地检测和识别手语的不同姿态和动作。

- 物体检测与手语分类:

- 项目通过 YOLO 模型进行物体检测,检测手语的具体动作和手势。YOLOv11 的高效性和准确性使得它能够在短时间内处理大量视频帧,实时进行检测和分类。

- 该模型能够区分不同的手语符号,并根据手语的具体动作进行分类,如字母、单词或句子等。

主要功能

- 手语检测:

- 使用 YOLOv11 模型对视频中的手语手势进行检测。模型能够实时处理视频,快速定位并识别出手语手势的位置和类型。

- 手语分类:

- 系统可以对不同的手语手势进行分类,包括字母、单词等,能够自动识别多种手语手势并进行相应分类。

- 视频处理与推理:

- 支持从视频流或静态图像中检测手语,能够在视频帧中找到并标注手语手势的位置。

- 实时检测:

- 该项目通过高效的 YOLOv11 算法实现实时检测功能,适合应用在需要快速反馈的场景中,如手语翻译设备或应用程序。

- 多类别检测:

- 可以同时识别多个手语手势,并在同一帧视频中检测出多个手的动作。

适用场景:

- 手语识别与翻译系统:

- 该项目的成果可以集成到手语翻译系统中,帮助聋哑人士与普通人进行沟通。系统可以自动识别聋哑人的手语手势并实时翻译成文本或语音,反之也可以通过语音转换成手语提示,辅助沟通。

- 教育与学习:

- 手语学习者也可以利用该系统进行练习,系统能够自动检测和纠正手势动作,帮助学习者更快掌握标准的手语动作。

- 教育机构可以将此系统应用于课堂教学中,为聋哑学生提供更好的互动工具。

- 智能手语设备:

- 该系统可以嵌入到智能设备中,如手语识别的智能手环或AR眼镜等,为用户提供实时手语识别和翻译功能。

项目地址:https://www.kaggle.com/code/duygujones/sign-language-detection-using-yolo11

妙言妙语AI,多模型集成,引领AI功能新潮,一站式解决你的创意与效率需求,妙言妙语AI它不仅仅是一个AI平台,更是一个集成了多种顶级大模型的集合体。