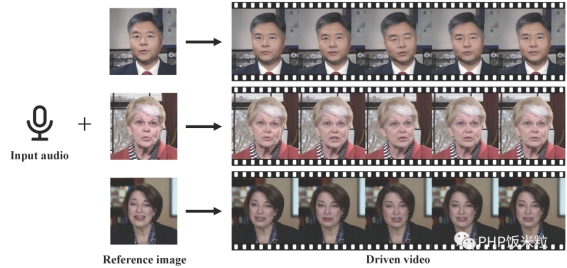

VividTalk:用一张照片和一段音频让人物栩栩如生地说话

发布时间:2024年06月06日

引言

在数字时代,技术的进步正在不断突破我们对现实与虚拟的界限。最新的突破来自VividTalk项目,这是一个能够将单张照片和一段音频结合起来,创造出仿佛真人在说话的视频的技术。这个技术不仅有望改变数字媒体的生产方式,也为虚拟现实和人工智能的应用开辟了新的道路。

VividTalk技术简介

VividTalk的核心功能是使用一张静态照片和音频录音,生成一个动态的、看似真实的讲话视频。这个过程涵盖了多种语言和风格,如真实风格和卡通风格,使其应用范围广泛。由南京大学、阿里巴巴、字节跳动和南开大学联合开发的这一项目,在技术层面上展现了巨大的潜力和创新性。

技术合作

这一跨学科项目的合作伙伴包括了中国领先的高等教育机构和科技公司。他们的共同努力使VividTalk成为了一个前沿技术的典范,展示了学术界和工业界合作的巨大潜力。

技术详解

音频到3D网格的映射: 在这一步骤中,VividTalk使用先进的算法将输入的音频映射到3D网格上,模拟表情运动和头部运动。这包括了混合形状和顶点偏移的使用,为模型提供了高度的表达能力。

网格到视频的转换: 利用双分支运动-VAE和生成器,VividTalk将3D网格运动转化为2D视频。这一过程不仅保证了运动的平滑性,也保持了视觉的连贯性和逼真度。

视觉质量与真实感

VividTalk生成的视频不仅在视觉上质量高,而且在嘴唇同步和面部表情上展现了显著的提升。这意味着视频中的人物不仅看起来真实,而且他们的表情和嘴型与音频完美匹配,为观众提供了一个沉浸式的体验。

结语

随着VividTalk技术的不断发展,我们可以预见其在数字媒体制作、虚拟现实和人工智能等领域的广泛应用。它不仅代表了技术进步,也为创造更加丰富和互动的数字体验提供了新的可能性。

点击原文查看项目及演示:https://humanaigc.github.io/vivid-talk/

出自:https://mp.weixin.qq.com/s/Wphq3c9fd5XVGBapUXY4MA

ideezy是一个提供高清甚至是 4K 分辨率的视频影片素材下载的网站,网站主要以分享免费的高清视频素材为主,被很多视频博主喜爱,已经成为全球最大视频素材网站之一。