使用stable diffsion对老照片进行AI高清放大修复

发布时间:2024年06月06日

周末朋友交代了一个活,让我帮他把一张模糊的老照片放大修复一下。

多年前我曾经用PS修复过一些老照片,但PS修复工作量非常大,主要是用印章工具一点点的把污渍痕迹消除掉,然后再放大处理。

一张照片往往耗时几个小时甚至几天才能获得比较满意的效果。

现在有了AI工具,一切变得简单了。

仅stable diffsion,就有两种高清放大的方法。

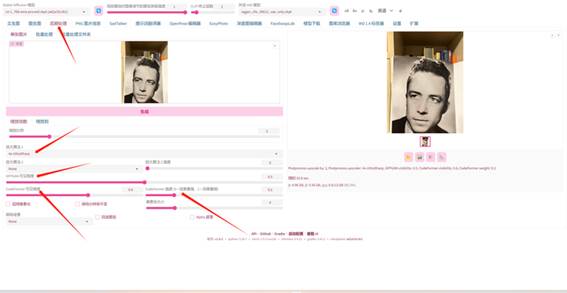

一、后期处理

使用了秋叶的一键包安装的标准WebUI,会自带放大功能。

点击后期处理即可进入。

1、算法推荐:4x-UltraSharp

算法文件下载:https://www.123pan.com/s/ueDeVv-YmKI.html 提取码:lgyh

安装路径:models\ESRGAN

2、GFPGAN 可见程度

推荐选0.5-0.8。

GFPGAN只负责放大,没有细节。

3、CodeFormer 可见程度

推荐0.5-0.8

4、CodeFormer 强度 (0 = 效果最强,1 = 效果最弱)

推荐0.2-0.5

CodeFormer 是增加细节的,但AI增加的细节过多可能会让原图变的不真实,可根据需要调整可见度和强度。

5、放大倍数

推荐2倍,更高的话,视显存大小而定。如果你是4090,就当我什么也没说。

后期处理的放大,优点是简单容易上手,缺点是效果略微差那么点事,不够精致。

普通的放大可以应付,如果需要更加精致的修复放大,推荐使用StableSR。

二、StableSR脚本放大

该放大功能相对复杂,使用了三个模型和一个脚本,同时还要安装插件。

插件地址:

https://gitcode.net/ranting8323/sd-webui-stablesr.git

1、模型下载

https://www.123pan.com/s/ueDeVv-PmKI.html 提取码:lgyh

2、模型安装路径

下载后得到三个模型文件,分别安装如下目录

VAE模型,models\VAE\vqgan_cfw_00011_vae_only.ckpt

细节增强模型,extensions\sd-webui-stablesr\models\webui_768v_139.ckpt

(需要注意的是,stablesr插件装完后,是没有extensions\sd-webui-stablesr\models\这个目录的,需要手工创建,然后再把细节增强模型拷贝过去。)

基础模型,models\Stable-diffusion\v2-1_768-ema-pruned.ckpt

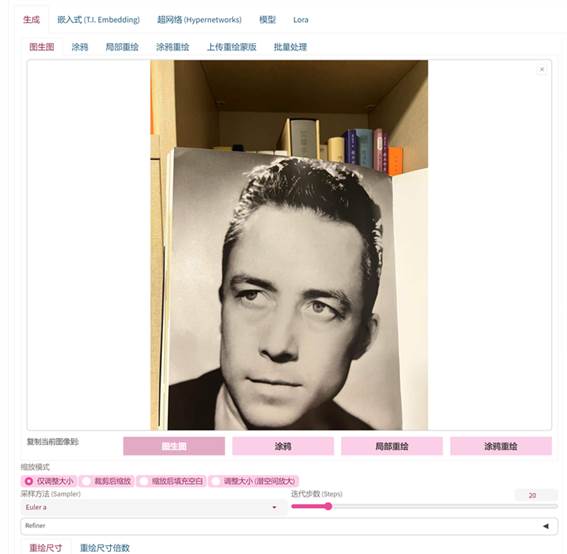

3、模型选择

使用图生图功能,大模型选择v2-1_768-ema-pruned.ckpt,VAE模型选择vqgan_cfw_00011_vae_only.ckpt

4、放大

图生图界面上传要放大的图片,都选择默认。

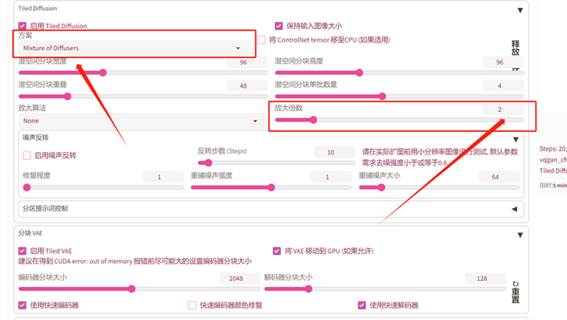

启用Tiled Diffusion和Tiled VAE(否则会爆显存)

只需要修改Tiled Diffusion的两个选项,方案改为Mixture of Diffusers,放大倍数改为2,其余均使用默认。

脚本选择StableSR,SR模型选择webui_768v_139.ckpt

然后选择生成图片!

正向提示词空着即可。

官方推荐使用负面提示词:3d, cartoon,

anime, sketches, (worst quality:2), (low quality:2)

根据我的实测效果,可用可不用。

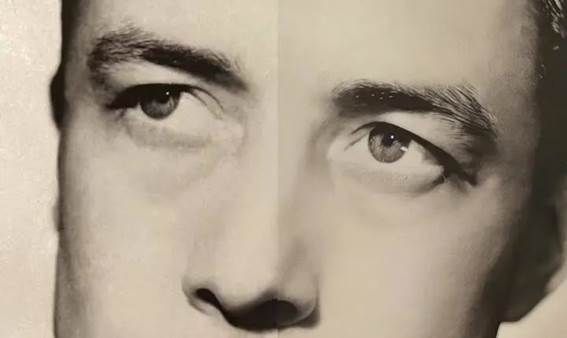

对比一下效果,左边是原图,右边是放大后的。

画面细腻,细节增强。

三、模型下载

https://www.123pan.com/s/ueDeVv-PmKI.html 提取码:lgyh

出自:https://mp.weixin.qq.com/s/PmRosg04Gup6N8X3WyoIbw

Stockimg AI 是一款基于人工智能技术的图片生成工具。通过 Stockimg AI,您 可以生成各种高质量的图片素材,包括壁纸、库存图片、徽标等。