Ollama 与 Dify:AI 应用开发的强强联合

发布时间:2024年07月30日

介绍

随着大型语言模型(LLM)的快速发展,它们为 AI 应用开发提供了强大的功能和灵活性。然而,在本地环境中部署和管理 LLM 仍然是一项挑战。Ollama和 Dify 两个开源项目为解决这一挑战提供了强大的解决方案。

Ollama 是一个本地推理框架,允许开发人员轻松地在本地部署和运行 LLM,例如 Llama 3、Mistral 和

Gemma。Dify 是一个 AI 应用开发平台,提供了一套完整的工具和 API,用于构建、管理和部署 AI 应用。

本文将介绍Ollama和Dify的功能和优势,并展示如何将它们结合使用来快速开发和部署AI应用。

准备工作

在开始使用

Ollama 和 Dify 之前,您需要准备以下环境:

·

一台运行 macOS、Windows 或 Linux 操作系统的计算机

·

·

安装 Python

3.7 或更高版本

·

·

安装 Docker

·

核心技术

下载安装 Ollama

去Ollama 官网:(https://ollama.com),下载按照对应版本的 ollama

使用 Ollama 部署本地模型

Ollama 提供了一种简单的方法来部署 LLM 到本地环境。您可以使用 Ollama 的命令行界面或图形界面来完成此操作。

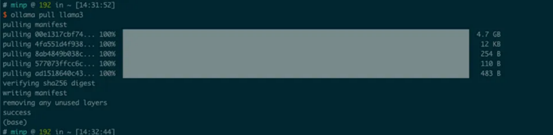

命令行界面

要使用命令行界面部署

LLM,您可以使用以下命令:

·

ollama pull <model-name>

例如,要部署

Llama 3 模型,您可以使用以下命令:

·

ollama pull llama3

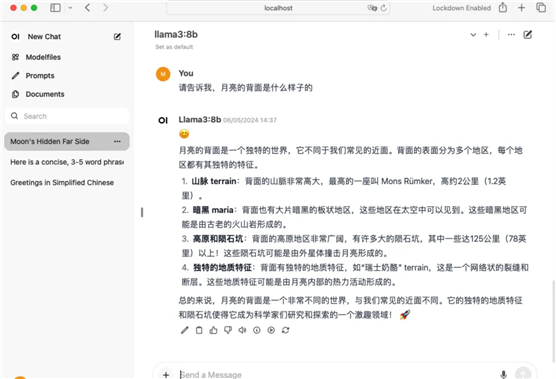

图形界面

要使用图形界面部署

LLM,您可以使用 Ollama 的 Web 界面。您可以通过安装 Open-WebUi在浏览器中输入以下 URL 来访问 Web 界面:

Open-WebUi

安装Docker命令

·

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

·

http://localhost:3000

在 Web 界面中,您可以选择要部署的模型以及模型的配置选项。

使用 Dify 进行应用开发和模型管理

DIfy 概述

Dify 提供了一套完整的工具和 API,用于构建、管理和部署 AI 应用。您可以使用 Dify 的以下功能:

·

代理能力😀 ify提供了一个代理层,可以将 LLM 的功能抽象为简单的 API 调用。这使得开发人员可以轻松地将 LLM 集成到他们的应用中。

·

·

模型管理😀 ify提供了一套工具来管理 LLM 的生命周期,包括模型的部署、更新和删除。

·

·

性能优化😀 ify提供了工具来监控 LLM 的性能并进行优化。

·

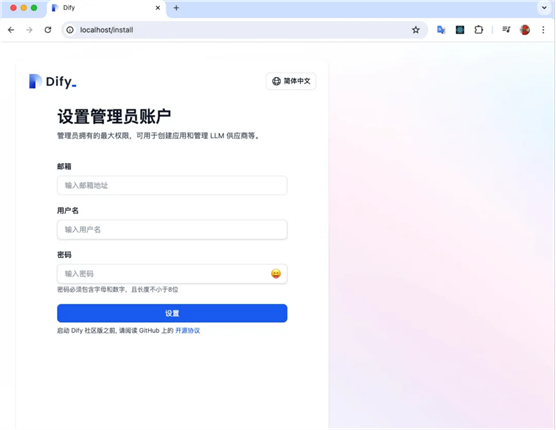

DIfy 部署

·

# clone dify 源码

git clone https://github.com/langgenius/dify

# 使用 docker compose 部署

cd dify/

dockerdocker-compose up -d

访问 http://localhost/install

地址

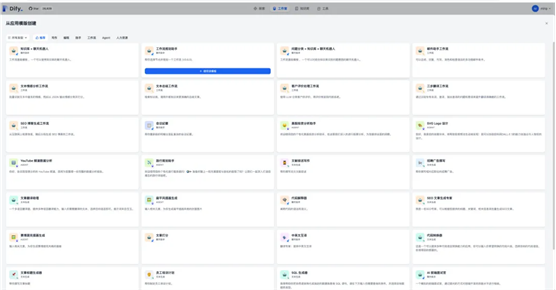

DIfy 支持的应用模板

实战案例

以下是一个使用

Ollama 和 Dify 构建简单 AI 应用的示例:

应用概述

该应用程序是一个问答系统,它使用 LLM 来回答用户的问题。

应用程序开发

·

使用 Ollama 部署 Llama 3 模型。

·

·

使用 Dify 创建一个新的应用程序项目。

·

·

在应用程序项目中,添加一个代理,该代理使用 LLM 来回答用户的问题。

·

·

编写代码来处理用户输入和输出。

·

应用程序部署

您可以使用 Dify

将应用程序部署到本地环境或生产环境。

性能优化与管理

您可以使用 Dify

的以下功能来优化应用程序的性能:

·

监控😀 ify提供了工具来监控 LLM 的性能指标,例如 CPU 使用率、内存使用率和响应时间。

·

·

优化😀 ify提供了工具来优化 LLM 的性能,例如调整模型配置或使用 GPU 加速。

·

问题与解决方案

在使用 Ollama

和 Dify 时,您可能会遇到以下问题:

·

模型部署失败:如果模型部署失败,请检查模型配置是否正确。

·

·

应用程序性能不佳:如果应用程序性能不佳,请使用 Dify 的监控工具来识别性能瓶颈。

·

作为一名AI应用的独立开发者,每日工作流程可能如下:

1.

早晨:检查和更新模型

— 使用 Ollama 检查是否有任何新的或更新的模型版本可用。如果有,我会下载并更新本地模型库。

2.

上午:开发和测试 —

利用 Dify 的开发环境开发新的应用功能。这可能包括编写代码来集成大型语言模型的输入和输出,或使用 Dify 提供的 API 进行模型调用和管理。

3.

中午:休息和学习 —

利用休息时间阅读最新的 AI 和机器学习相关信息,包括新的模型架构和开发工具,以保持知识更新。

4.

下午:优化和部署 —

分析应用性能,使用 Dify 的可观察性工具来识别任何潜在的瓶颈或优化机会。然后,对模型进行调整,使用 Ollama 在本地测试更改。

5.

晚上:文档和社区参与

— 更新开发文档,记录当天的工作和学习心得。可能还会参与相关的线上社区,分享经验,解答问题,或获取他人的反馈。

6.

结论

Ollama 和 Dify 是两个强大的开源项目,可以帮助开发人员快速开发和部署 AI 应用。通过结合使用这两个工具,您可以利用 LLM 的强大功能来构建创新和引人入胜的应用程序。

出自:https://mp.weixin.qq.com/s/bNo4O0gy_9UZG34OeteTRQ

参考资料

·

Ollama 官方网站: https://ollama.ai/

·

·

Dify 官方网站: https://dify.ai/

·

·

Mistral 官方网站: https://mistral.ai/

·

出自:https://mp.weixin.qq.com/s/bNo4O0gy_9UZG34OeteTRQ

如果你想要了解关于智能工具类的内容,可以查看 智汇宝库,这是一个提供智能工具的网站。

在这你可以找到各种智能工具的相关信息,了解智能工具的用法以及最新动态。

Hardhat 是以太坊软件的开发环境。它由用于编辑、编译、调试和部署智能合约和 dApp 的不同组件组成,所有这些组件共同创建一个完整的开发环境。