本地部署安装 Llama 3.2 大模型,支持1B、3B、11B、90B 模型

发布时间:2024年09月30日

安装步骤:

1、通过Ollama进行部署 ,支持多平台!Windows / Mac /Linux 都可以运行 【点击下载】

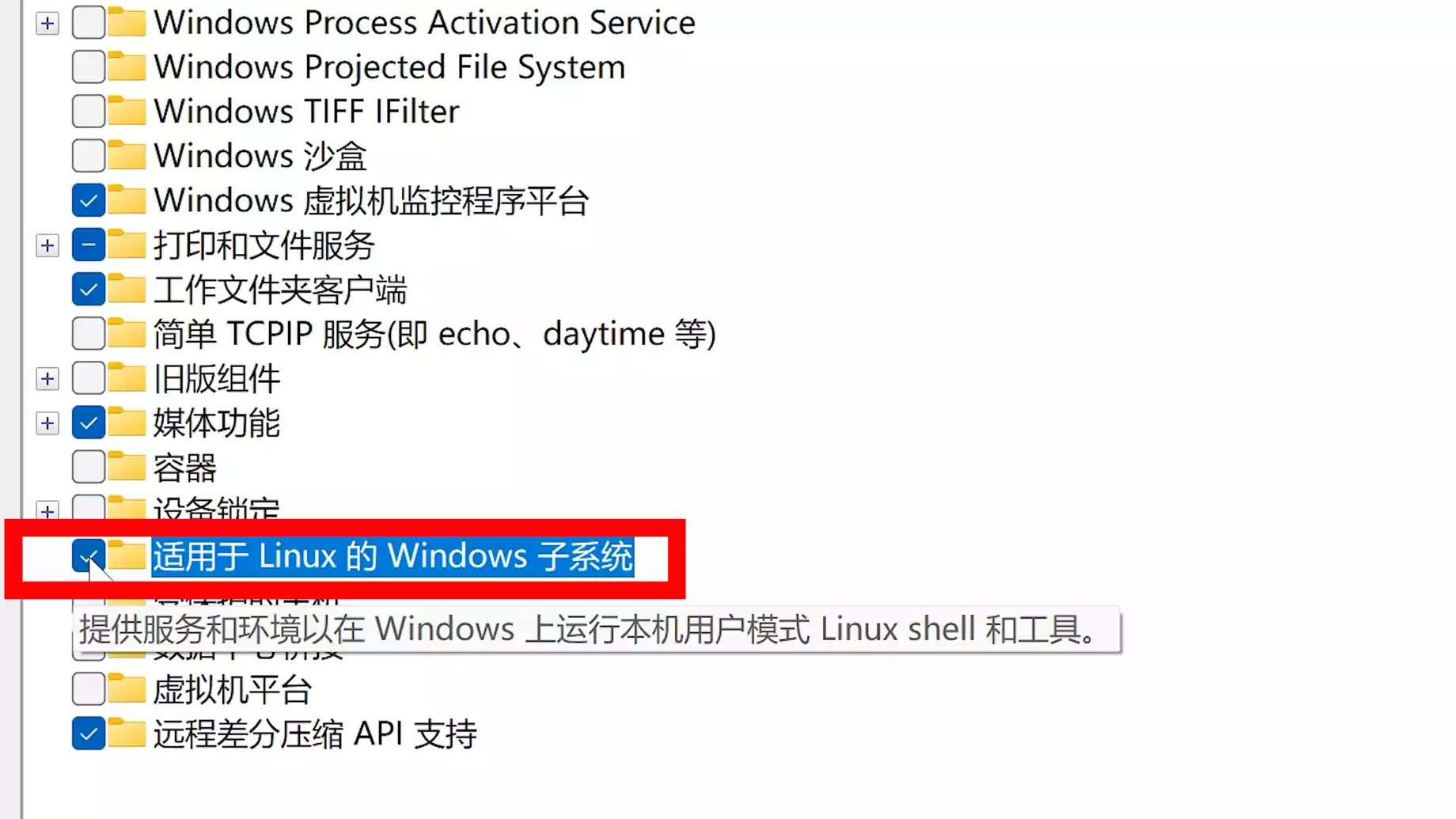

并在 Windows 上打开 WSL 功能:

2、安装Docker Desktop :【点击前往】

然后本地安装webUI

(1)在CPU下运行:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

(2)支持GPU运行:

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

安装完成通过本地地址:http://127.0.0.1:3000 进行访问,然后在里面下载安装Llama 3.2 模型

Llama 3.2 11B 本地部署教程:【点击前往】 注意:11B模型 需要22G以上的显存才能运行

当然如果你不想本地部署安装,或者显卡不支持,也可以直接在线体验 !

Llama 3.2 11B在线使用:【点击前往】 支持图片识别功能

如果你想要了解关于智能工具类的内容,可以查看 智汇宝库,这是一个提供智能工具的网站。

在这你可以找到各种智能工具的相关信息,了解智能工具的用法以及最新动态。

爱校对,免费高效的错别字检查工具,来自清华大学人机交互实验室,提供智能校对、