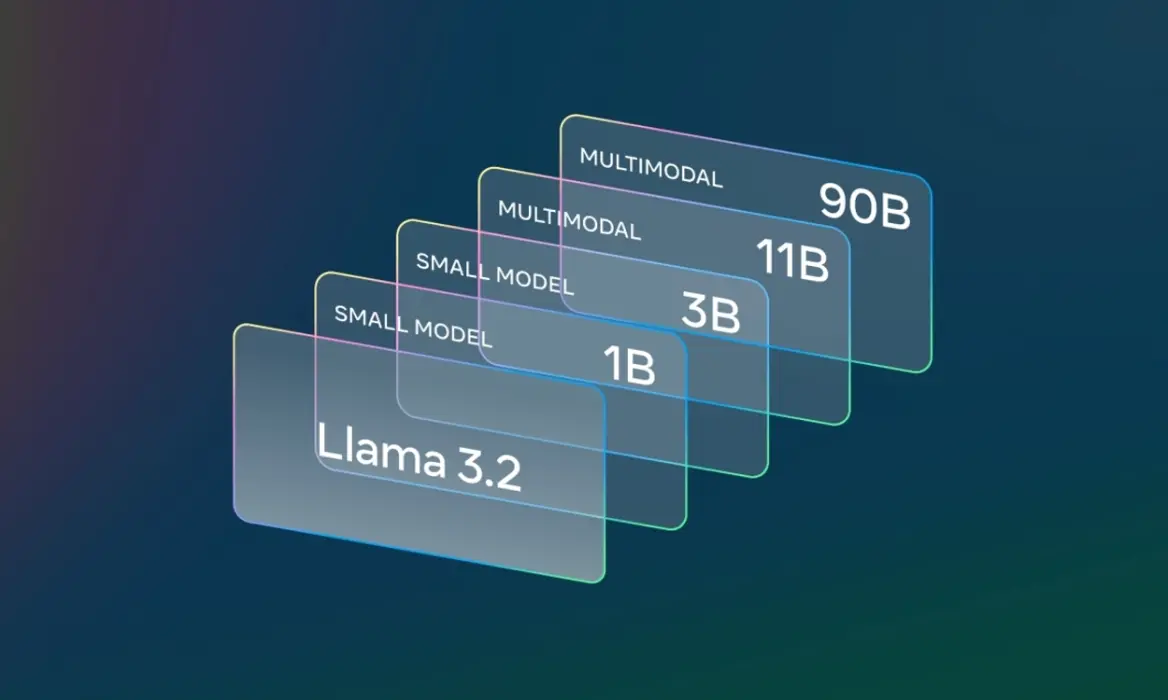

Llama 3.2 本地部署教程 ,11B模型、支持视觉、图片识别功能!

发布时间:2024年09月30日

Llama 3.2 11B 视觉模型下载方式

1、从Hugging Face模型库下载Llama 3.2 11B的模型文件。模型文件可以通过API或者手动下载。

2、网盘打包下载:【点击前往】

1. 安装Python和pip

首先,确保你已经安装了Python 3.8或以上版本。如果还没有,可以通过以下步骤安装。

下载Python:

从Python官网下载适用于Windows的最新版本Python。安装时,确保勾选“Add Python to PATH”选项,以便命令行可以直接使用Python。

检查Python和pip是否安装成功:

pip --version

python --version pip --version

如果成功,会显示Python和pip的版本号。

2. 安装CUDA和PyTorch

比如使用 RTX 4090进行加速,需要安装支持CUDA的PyTorch版本。

安装CUDA

- 下载并安装CUDA工具包(确保与你的显卡型号兼容)。

- 安装NVIDIA cuDNN(CUDA的深度学习库)。

安装支持CUDA的PyTorch:

打开命令提示符并运行以下命令,安装支持CUDA 11.8的PyTorch:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

这会安装带有GPU加速功能的PyTorch版本,确保充分利用RTX 4090的计算性能。

3. 安装Llama 3.2 11B模型相关依赖

接下来,你需要安装Transformers库以及其他依赖项,用来加载Llama 3.2模型。

安装Transformers和其他依赖:

pip install sentencepiece # Llama模型所需的分词工具

pip install transformers pip install sentencepiece # Llama模型所需的分词工具

4. 下载和配置Llama 3.2 11B模型

1、从Hugging Face模型库下载Llama 3.2 11B的模型文件。模型文件可以通过API或者手动下载。

2、网盘打包下载:【点击前往】

加载Llama 3.2 11B模型

你可以使用以下代码下载并加载模型:

# 下载并加载Llama 3.2 11B模型

tokenizer = LlamaTokenizer.from_pretrained("path_to_llama_3_2_11b_model")

model = LlamaForCausalLM.from_pretrained("path_to_llama_3_2_11b_model").to("cuda")

from transformers import LlamaTokenizer, LlamaForCausalLM

# 下载并加载Llama 3.2 11B模型

tokenizer = LlamaTokenizer.from_pretrained("path_to_llama_3_2_11b_model")

model = LlamaForCausalLM.from_pretrained("path_to_llama_3_2_11b_model").to("cuda")

请确保将path_to_llama_3_2_11b_model替换为实际的模型路径或模型ID。

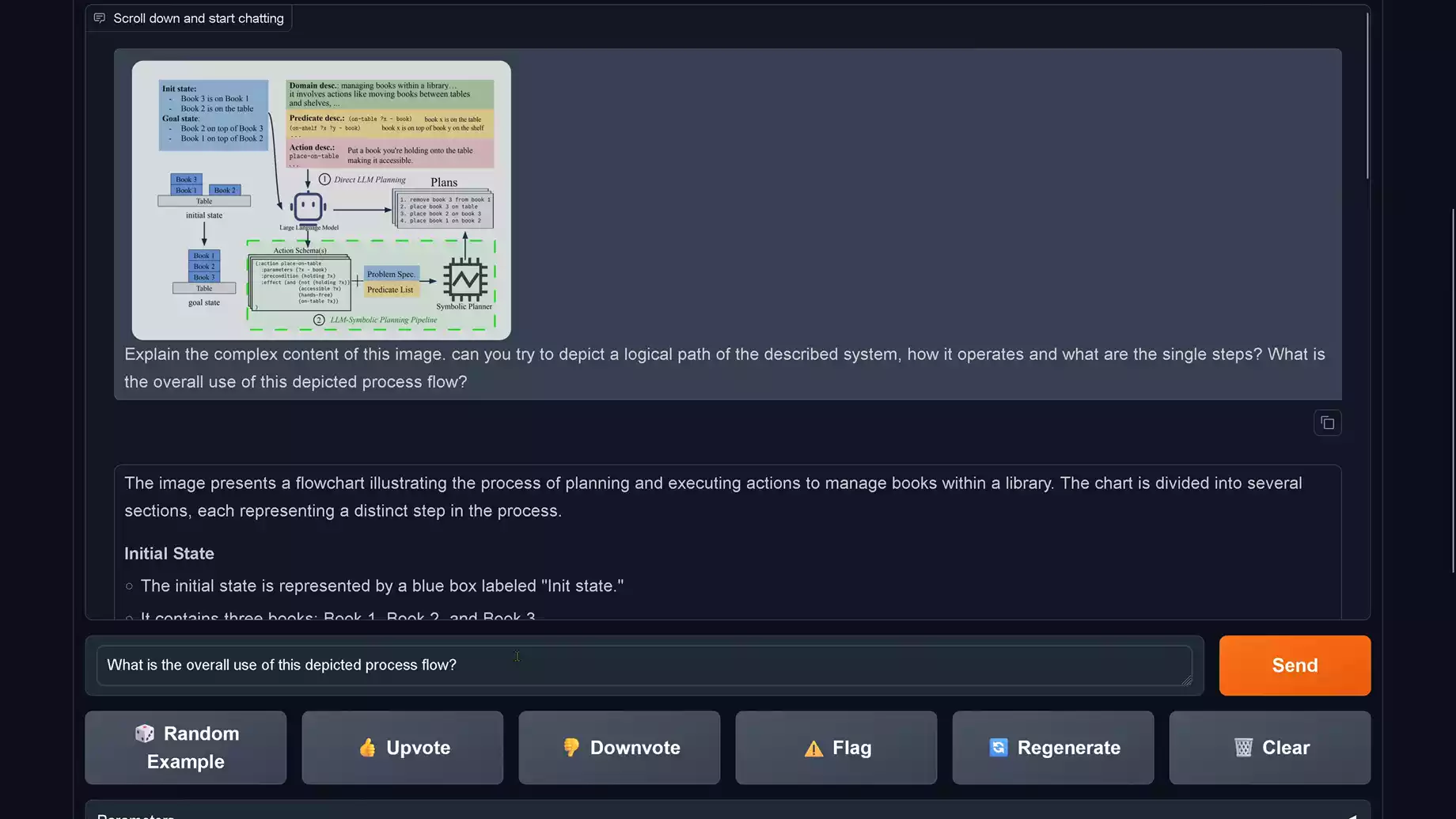

5. 安装Gradio并创建UI

安装Gradio

pip install gradio

创建Gradio界面

在Windows系统上,你可以创建一个Gradio界面,让用户可以通过浏览器与Llama 3.2 11B模型交互:

from transformers import LlamaTokenizer, LlamaForCausalLM

import torch

from PIL import Image

# 加载Llama 3.2 11B模型

tokenizer = LlamaTokenizer.from_pretrained("path_to_llama_3_2_11b_model")

model = LlamaForCausalLM.from_pretrained("path_to_llama_3_2_11b_model").to("cuda")

# 定义推理函数,处理图片和文本

def llama_generate(image, text):

# 假设处理图像功能在此

# 可以在这里加载图像模型并处理图片

input_ids = tokenizer(text, return_tensors="pt").input_ids.cuda()

output = model.generate(input_ids, max_length=200)

return tokenizer.decode(output, skip_special_tokens=True)

# 使用Gradio构建UI,添加图片和文本输入

demo = gr.Interface(fn=llama_generate,

inputs=["image", "text"],

outputs="text",

title="Llama 3.2 11B 模型(图片+文本)")

# 启动界面

demo.launch()

import gradio as gr

from transformers import LlamaTokenizer, LlamaForCausalLM

import torch

from PIL import Image

# 加载Llama 3.2 11B模型

tokenizer = LlamaTokenizer.from_pretrained("path_to_llama_3_2_11b_model")

model = LlamaForCausalLM.from_pretrained("path_to_llama_3_2_11b_model").to("cuda")

# 定义推理函数,处理图片和文本

def llama_generate(image, text):

# 假设处理图像功能在此

# 可以在这里加载图像模型并处理图片

input_ids = tokenizer(text, return_tensors="pt").input_ids.cuda()

output = model.generate(input_ids, max_length=200)

return tokenizer.decode(output, skip_special_tokens=True)

# 使用Gradio构建UI,添加图片和文本输入

demo = gr.Interface(fn=llama_generate,

inputs=["image", "text"],

outputs="text",

title="Llama 3.2 11B 模型(图片+文本)")

# 启动界面

demo.launch()

6. 启动Gradio应用

保存上面的脚本为 llama_gradio_app.py,然后在命令提示符中运行以下命令:

python llama_gradio_app.py

Gradio将在命令行中生成一个URL,你可以通过这个URL在浏览器中访问Gradio界面,并与Llama 3.2 11B模型进行交互。

7. 可选优化

- GPU加速:确保模型在GPU上运行。你可以通过以下代码将模型加载到GPU中:

model = model.to("cuda")

调优生成结果:可以通过修改generate函数中的max_length参数来控制生成文本的长度。

如果你想要了解关于智能工具类的内容,可以查看 智汇宝库,这是一个提供智能工具的网站。

在这你可以找到各种智能工具的相关信息,了解智能工具的用法以及最新动态。

机器之心是中国领先的人工智能科技媒体,提供最新的AI新闻、研究论文和产业动态,专业的人工智能信息服务平台。