数字人起飞!字节Loopy对口型功能在即梦上线 可根据语境匹配表情和情绪

发布时间:2024年09月27日

还记得月初刚发布时就让大家惊艳不已的字节新项目Loopy吗?

这个让数字人声音完美匹配画面还匹配表情和情绪的对口型项目已经正式在即梦上线了。

AIbase体验了一下,效果非常不错,可以说是目前支持中文效果最好的对口型服务了。

以往,对口型视频往往存在一个通病,那就是看似嘴型对上了,但总感觉这个声音不是他发出来的,以至于大家看对口型视频的时候,会有一种割裂感。

字节跳动和浙江大学的科研团队联合开发的基于音频驱动的视频扩散模型LOOPY完美解决了这个问题。

不同于以往的对口型只是张张嘴,Loopy可以让对口型视频中的角色在说话或唱歌时,还自动带上该语境下相应的语气,情绪和表情。

它可以精准地"指挥"虚拟形象的每一个细微动作,例如叹息等非语音动作、情绪驱动的眉毛和眼睛运动以及自然的头部运动。

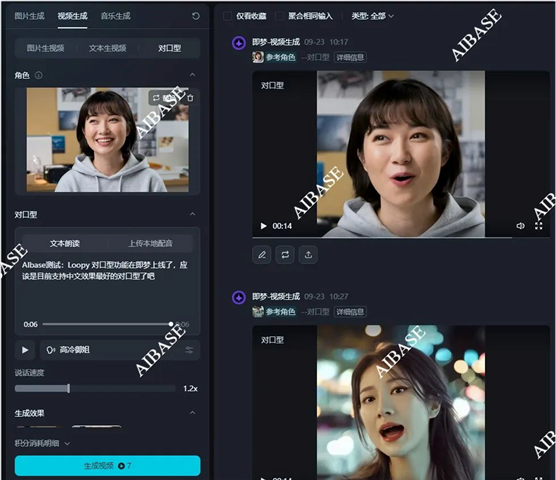

目前,这一功能已经集合进字节旗下即梦的视频生成模块内:

AIbase上传了一张女孩的照片测试一下,

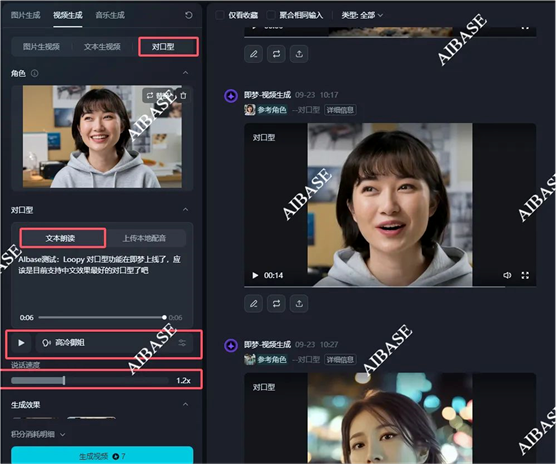

即梦里面的对口型目前可以选择两种对口型方式:

1、文本朗读

即梦的操作基本都很简单,只需要上传你要对口型的角色图片或视频,然后输入文本,选择一个配音即可。

2、上传本地配音

而且,你不但可以让她说话,还可以上传一段唱歌的音频,让她开口唱歌:

效果真不错,不仅口型对上了,而且声音不会让人有割裂的感觉,仿佛女孩的原声就是这样的。

比较让AIbase惊喜的是,它在对口型的时候,还会考虑到喉结,眉毛等这些很细微的变化细节。使得整体的视频更加真实。

感兴趣的可以自行体验哦~

即梦产品入口:https://top.aibase.com/tool/jimeng

如果你想要了解关于智能工具类的内容,可以查看 智汇宝库,这是一个提供智能工具的网站。

在这你可以找到各种智能工具的相关信息,了解智能工具的用法以及最新动态。

一款人工智能驱动的工具,可帮助您编写更好、更具吸引力的营销内容。它使用人工智能来撰写经过验证的、高转化率的广告、电子邮件、网站、列表、博客等文字。